*)가중치 규제(weight Regularization)는 Normalization과 똑같이 번역 되는 경우가 많은데, 혼동을 주의 해야한다.

overfitting을 방지하는 여러 방법중에 가중치가 큰 값을 가지지 않도록 하는 방법이 있는데 이 때 regularization이 사용된다. 모델의 가중치가 큰 값을 가질 때, 불이익을 주어 값을 낮춘다.

Regularization은 Cost함수를 변형시켜 큰 가중치를 규제한다.

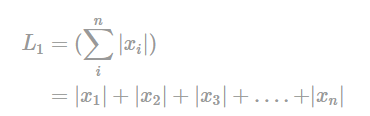

L1 Norm

L1 Norm은 벡터의 요소에 대한 절댓값의 합

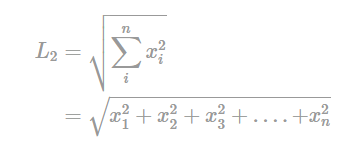

L2 Norm

파이토치에서는 옵티마이저의 weight_decay 매개변수를 설정함으로써 L2 규제를 적용할 수 있다.

optimizer=torch.optim.Adam(model.parameters(), lr=le-4, weight_decay=1e-5)

'딥러닝' 카테고리의 다른 글

| 코랩 런타임 유지 (0) | 2022.08.19 |

|---|---|

| Open CV (0) | 2022.08.02 |

| 손실함수 정리 (0) | 2022.07.27 |

| Sigmoid 함수 미분 (0) | 2022.07.27 |

| PyTorch로 simple_network 만들기 (0) | 2022.07.27 |